AWS Data Pipelineの概要

AWS Data Pipeline は、指定した間隔で、AWS の様々なコンピューティングサービスやストレージサービスとを連携させて、データ処理や移動を行うフルマネージドサービスです。簡単に書くとデータの移動や変換を自動化する機能です。

AWS Data Pipeline を使用すると、保存場所にあるデータに定期的にアクセスさせ、必要な変換と処理を行い、その結果を Amazon S3、Amazon RDS、Amazon DynamoDB、Amazon EMR などの AWS サービスに効率的に転送が出来ます。また、耐障害性があり、繰り返し可能で高可用性を備えた、単純ではないデータ処理ワークロードを容易に作成可能です。

AWS Data Pipeline では、リソースの可用性の保証がされており、再試行・タイムアウト、失敗した場合、通知するシステムの作成処理、オンプレミスのデータ格納庫に保管しているデータの移動と処理も可能になります。

AWS Data Pipelineの利点

フルマネージドサービス

AWS Data Pipelineは、AWSのフルマネージドサービスであるため、データ処理や移動に伴う基盤やソフトウェア、スケジューラ、管理などといった準備を考える必要がありません。

簡単にパイプラインを作成できる

AWS Data Pipelineは、ドラッグアンドドロップでスピーディにパイプラインを作成できます。また、よく使う前提条件が組み込まれているため、ロジックの記述がいりません。たとえば、Amazon S3 バケット名、及びチェックするファイルのパスを入力するのみで Amazon S3 ファイルの有無を確認でき、残りの作業は AWS DataPipeline が行います。

AWS Data Pipeline にはパイプラインテンプレートのライブラリが用意されており、テンプレートを使う事で複雑なパイプラインの作成も問題ありません。たとえば、規則的なログファイルの処理、Amazon S3 へのデータのアーカイブ、SQL クエリの定期的な実行などができます。

可用性が高い

AWS Data Pipeline は、アクティビティ実行の耐障害性を高めるべく、高可用性を備えた分散型インフラストラクチャ上に構築されています。

さまざまな機能を利用できる

AWS Data Pipelineでは、スケジュール設定や依存関係を追跡、エラー処理など のさまざまな機能を利用できます。

AWS Data Pipeline で、Amazon EMR ジョブの実行、データベースに対するSQLクエリの直接の実行、Amazon EC2 やユーザーのデータセンターで稼働しているアプリケーションなどを実行することで、複雑な手間をかけることなく、データ分析や処理ができるようになります。

スケーラブルに対応が可能

AWS Data Pipelineはスケーラブルに対応可能に設計されており、少ない処理から何百万の処理まで簡単に対応できます。また、マシンの送信台数に違いがあっても、シリアル送信でもパラレル送信の場合でも、送信作業は簡単です。

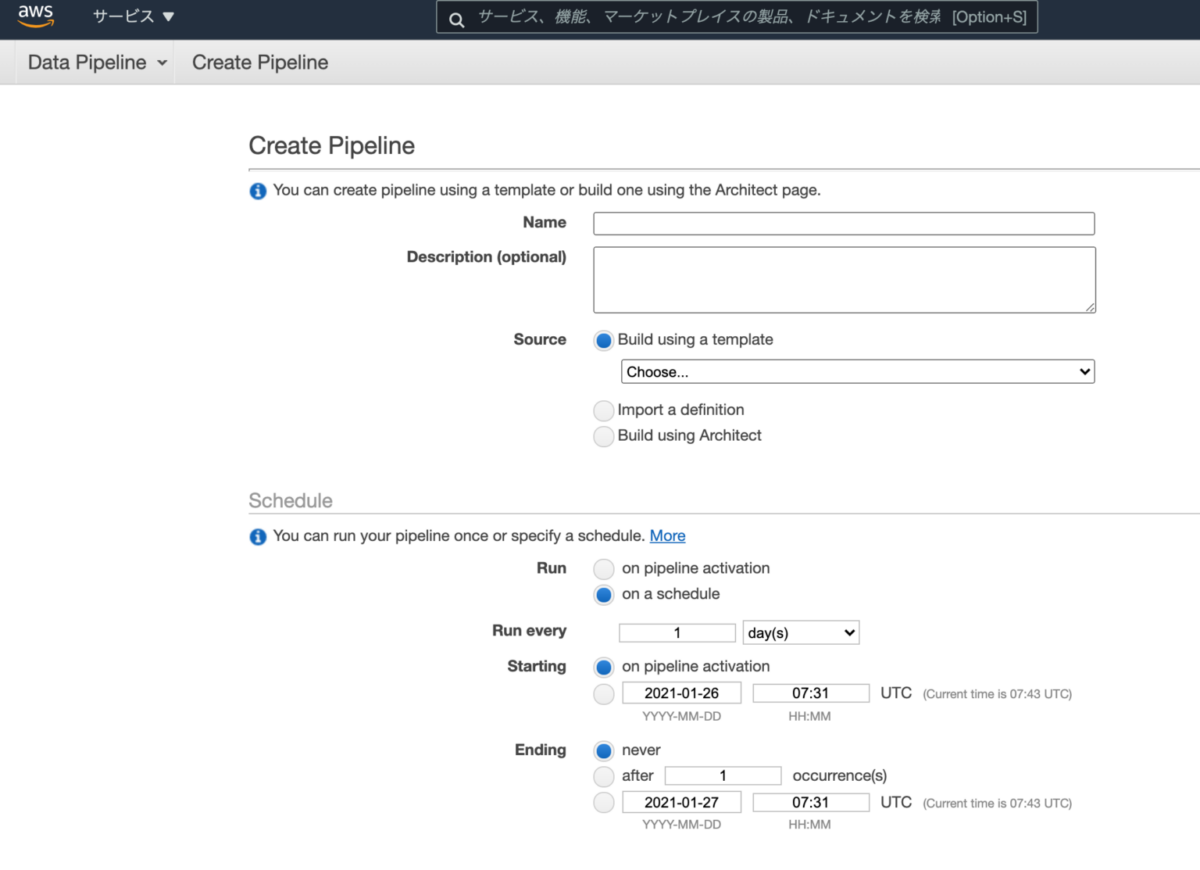

コンソールイメージ

参考資料